一、DS 介绍

DeepSeek是一家大模型初创公司,全称“杭州深度求索人工智能基础技术研究有限公司”,因2025年1月份发布并直接开源的DeepSeek-R1及V3模型被大众所熟知,此模型由中国团队自主研发,参数高达670亿,性能对标 OpenAI o1 正式版,一经发布是吓得OpenAI紧急发布尚不完善的o3模型,命名为o3-mini,这意味着中国在 AI 领域的技术实力大幅度增强,不仅提升了国内科技产业的竞争力,还推动了全球科技格局的变化。

二、准备工作

操作系统:Windows

硬件准备:没啥要求,现在市面的设备基本都可以跑,满血版跑不起来,咱1.5b的蒸馏版还跑不起来?

对于DeepSeek官方开源的版本,也就是我们常说的671b满血版本,本地PC部署基本是不可能的,因其模型4bit量化后大小还在400GB以上,在模型启动运行时,需要将所有数据全部加载至内存中,且根据量化值的大小占用有所不同,如8bit量化则内存占用较4bit将近乎翻倍,所以本地PC部署此版本几乎不太可能。

本地体验建议使用蒸馏版本模型,相对较小,且不必依赖强大的数据中心级GPU,如不在乎生成速度,CPU也能跑,常见有以下几个版本:

| 模型名称 | 模型大小 | 备注 |

| DeepSeek-R1-Distill-Qwen-1.5B | 1.1GB | 基于qwen蒸馏 |

| DeepSeek-R1-Distill-Qwen-7B | 4.7GB | 基于qwen蒸馏 |

| DeepSeek-R1-Distill-Llama-8B | 4.9GB | 基于llama蒸馏 |

| DeepSeek-R1-Distill-Qwen-14B | 9.0GB | 基于qwen蒸馏 |

| DeepSeek-R1-Distill-Qwen-32B | 20GB | 基于qwen蒸馏 |

| DeepSeek-R1-Distill-Llama-70B | 43GB | 基于llama蒸馏 |

| DeepSeek-R1 671B | 404GB | 未蒸馏,4bit量化 |

三、安装部署

1. 安装环境

我电脑的配置为:Intel i7-12700K,32GB内存,1TB SSD,NVIDIA GeForce RTX 3070 8G显存。

这里使用DeepSeek-R1-Distill-Qwen-7B进行演示,各位可根据自己设备的配置进行模型选择

| PC *1 | 系统 | Win 11 24H2 |

| CPU | 20核 | |

| 内存 | 32 GB | |

| 硬盘 | 1TB SSD | |

| GPU | NVIDIA RTX 3070 8G |

2. Ollama部署

为简化安装流程和降低使用门槛,尝鲜建议可使用Ollama进行部署,大部分开源客户端软件如Open WebUI、LobeChat、AnythingLLM、Cherry Studio等均支持Ollama API,可对接Ollama API后进行WEB或桌面端的使用。

Ollama官网:Ollama

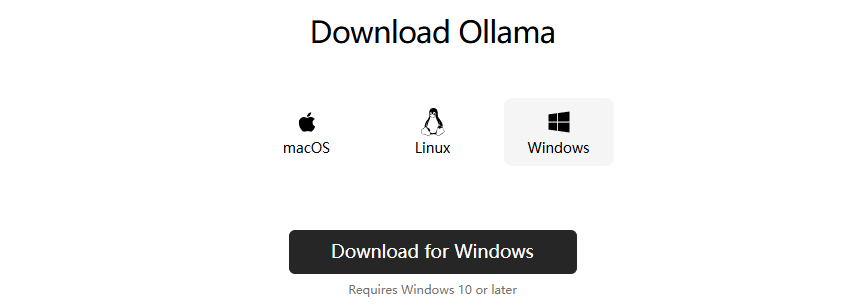

点击首页Download,根据系统进行选择,这里选择 Download for Windows

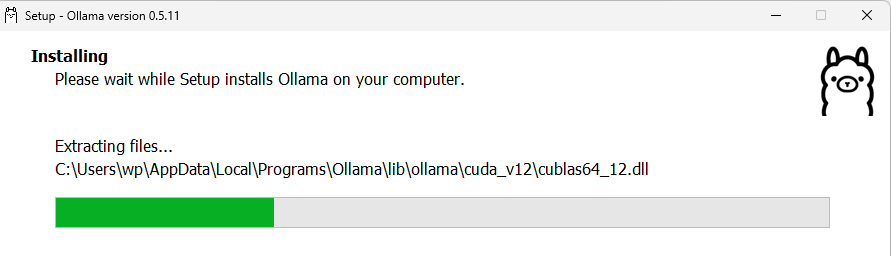

双击下载好的exe文件 install即可。

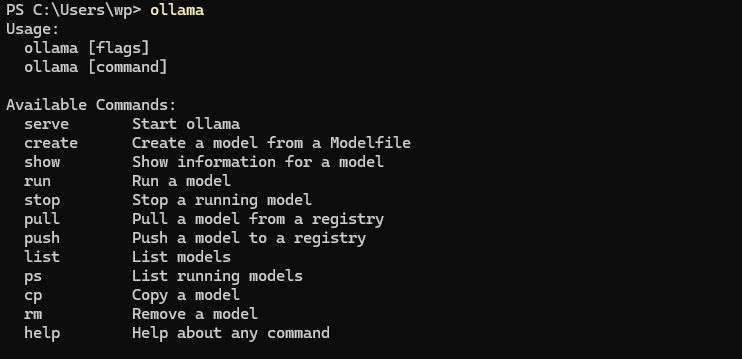

安装完成后会自动运行Ollama,打开PowerShell,输入Ollama回车,正常输出帮助信息代表安装成功。

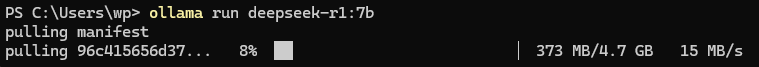

3. 模型拉取

Ollama支持模型清单:Ollama Model Search

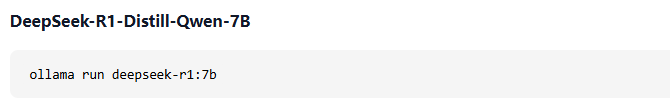

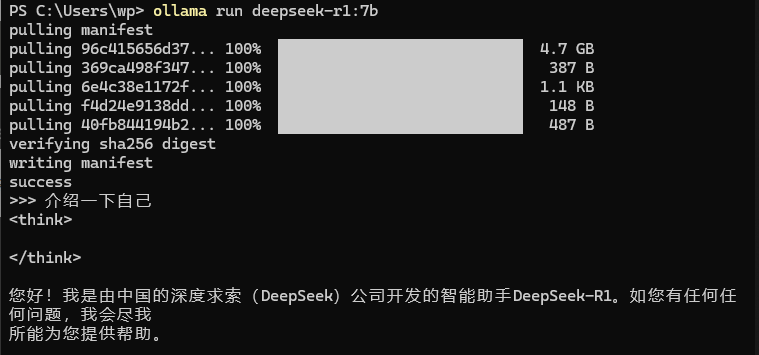

ollama run deepseek-r1:7b

单击deepseek-r1,即可选择不同参数模型,这里选择7b,复制启动命令至PowerShell即可拉取并运行。

4. 对话测试

无报错,进入 >>> 对话模式与其对话,回答正常,安装部署成功。

四、客户端对接

客户端选择较为多样,Web客户端可选:WebUI、LobeChat,桌面客户端可选:WebUI、LobeChat等。

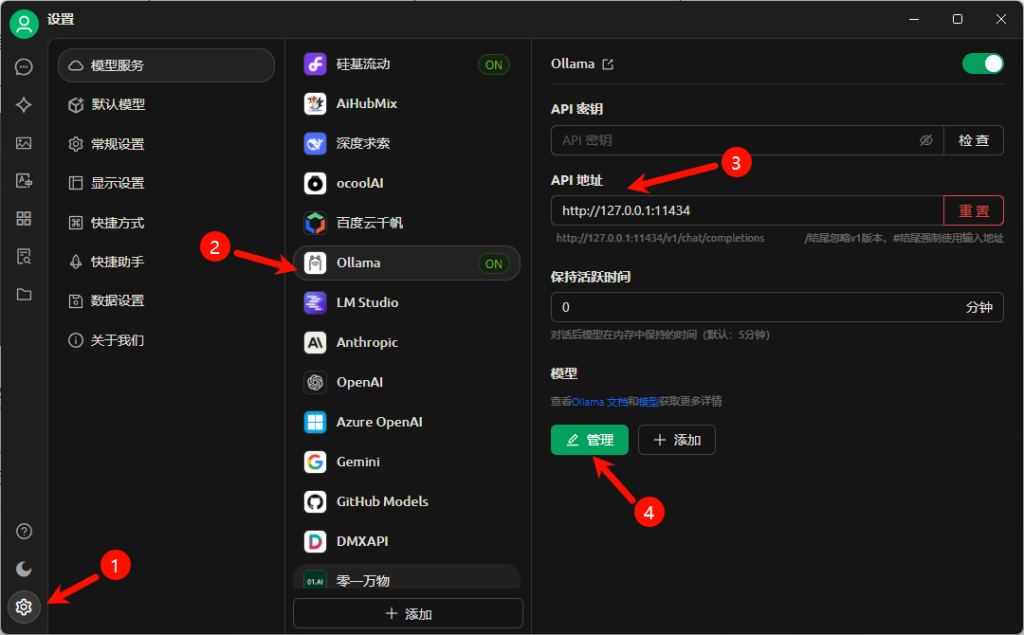

本次选用 Cherry Studio 作为演示,其他使用起来区别也不大,都是集成各模型服务厂商接口,如OpenAI、硅基流动、深度求索、月之暗面……. 到个平台申请API秘钥后即可直接调用。

Cherry Studio安装过程不再赘述,选择好安装位置,一路下一步即可。

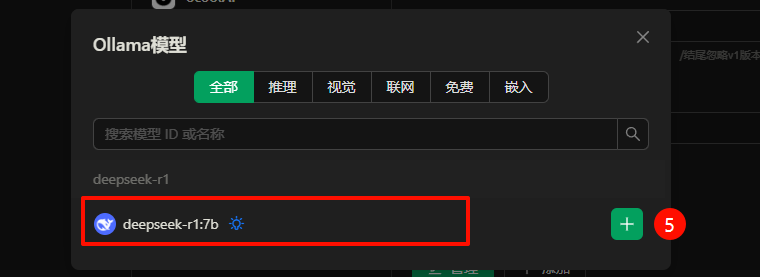

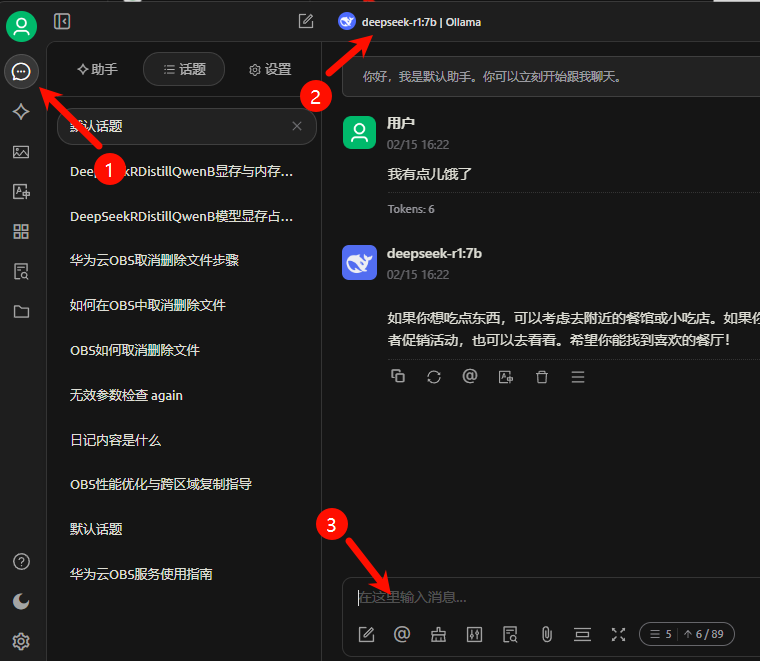

API地址:Ollama默认会启动 http://127.0.0.1:11434 端口的监听,输入到此处后点击管理,如成功连接至API,则会如下图列出已加载的模型列表,点击”+”添加。

回到会话界面,选择本地部署的“deepseek-r1:7b | Ollama”模型即可开始对话。

推理过程中GPU及VRAM利用率如图。

五. 没有算力怎么办?

1.可以考虑上云

- 上云就上天翼云,天翼云息壤平台准备了大量的算力资源,提供开箱即用的算力,A10、910B等均可按小时付费,一站式智算服务平台新老用户均可免费体验两周 2500万Tokens免费使用。

- 阿里云:GPU算力1折起,1.9元每小时,适合低价体验AIGC之旅【链接直达】

- 腾讯云:Cloud Studio 10000分钟免费算力/月,无需部署、即开即用。【链接直达】

- 华为云:3步在线体验DeepSeek昇腾云适配版200万Tokens免费领。【链接直达】

2.模型整合服务商

- 硅基流动:注册即赠送 2000万 Tokens,可使用升腾算力,可直接调取API使用。【链接直达】

相关推荐:

万万没想到

万万没想到

![记录一次WordPress插件Redis Object Cache报错“Redis 无法访问: Connection refused [tcp://127.0.0.1:6379]”故障处理方法-万万没想到](https://oss.wanpeng.life/wp-content/uploads/2024/07/a0f1e0603bc52f8-220x150.png)

评论前必须登录!

立即登录 注册